Erfahren Sie bei uns den umfassenden Vergleich: Virtualbox vs VMware. Entdecken Sie Unterschiede und wählen Sie die beste Lösung.

Entdecken Sie, was VirtualBox ist und wie diese leistungsstarke Virtualisierungssoftware Ihnen helfen kann, Betriebssysteme risikofrei zu testen und auszuführen.

XFS ist eines der robustesten Dateisysteme, die in Linux bereitgestellt sind. Es wurde ursprünglich von Silicon Graphics Inc. entworfen und 1994 auf ihrer UNIX-basierten IRIX-Plattform veröffentlicht. XFS ist bekannt für seine hohe Leistung beim Umgang mit großen Datenmengen und wird hauptsächlich auf Servern und Speicher-Arrays eingesetzt. Es bietet viele Features, die es optimal für große […]

Die Installation des Zabbix Agents ist ein wichtiger Schritt, um Ihr System effektiv zu überwachen und Probleme frühzeitig zu erkennen. In diesem Schritt-für-Schritt-Guide erfahren Sie, wie Sie den Zabbix Agent auf verschiedenen Plattformen wie Windows installieren können. Darüber hinaus werden wir Ihnen weitere Details zur Konfiguration des Zabbix Agents und zum Download zur Verfügung stellen. […]

Ein Incident in der IT ist ein Vorfall oder eine Störung, die den normalen Betrieb eines IT-Systems unterbricht. Dies kann durch Hardwarefehler, Softwarefehler, menschliches Versagen oder externe Angriffe verursacht werden. Incidents können verschiedene Auswirkungen haben, von leichten Störungen bis hin zu schwerwiegenden Problemen, die die Produktivität und den Geschäftsbetrieb beeinträchtigen. Incident Management befasst sich mit […]

ZFS ist ein fortschrittliches Dateisystem von Oracle (früher Sun Microsystems), das 2000 von Jeff Bonwick und Bill Moore entwickelt wurde. Es löst sowohl aktuelle als auch zukünftige Probleme in Bezug auf die Datenspeicherung. ZFS bietet viele praktische Vorteile, wie die effiziente Handhabung von Festplattenausfällen in einem RAID-Verbund, die Garantie der Datenintegrität und die Möglichkeit zur […]

In diesem Artikel möchten wir die Unterschiede zwischen den Firewall-Systemen IPFire und OPNsense beleuchten und Ihnen helfen, die beste Firewall-Lösung für Ihre Bedürfnisse zu finden. Wir werden die Leistung, Funktionen, Konfiguration, Vor- und Nachteile sowie die Sicherheitsmerkmale von IPFire und OPNsense vergleichen. Wichtige Erkenntnisse: Beide Firewall-Systeme, IPFire und OPNsense, bieten umfangreiche Sicherheitsmerkmale und solide Leistung. […]

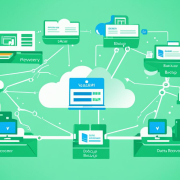

Ein Veeam Service Provider ist ein Technologiepartner, der erstklassige Lösungen für eine moderne Datensicherung bietet. Als Serviceprovider können wir die dynamischen Anforderungen unserer Kunden an das Datenmanagement erfüllen und übertreffen. Veeam hat speziell auf die Bedürfnisse von Serviceprovidern zugeschnittene Produkte und Programme, mit denen wir unser Business erfolgreich ausbauen können. Durch die Bereitstellung von Backup-as-a-Service […]

Zabbix ist eine Open-Source-basierte Überwachungssoftware, die Netzwerke und Anwendungen überwachen kann. In diesem Abschnitt werden wir eine Schritt-für-Schritt-Anleitung zur Installation des Zabbix Servers für Anfänger bereitstellen. Wir werden uns darauf konzentrieren, wie man den Zabbix Server unter dem Betriebssystem Raspbian (Wheezy) installiert und konfiguriert. Dieser Leitfaden richtet sich an Einsteiger und bietet eine einfache Anleitung […]