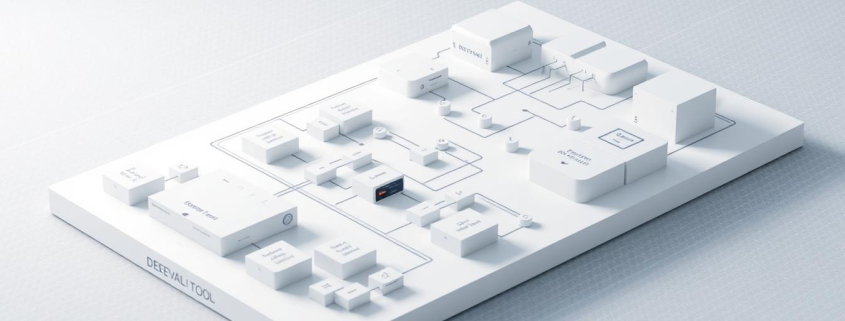

Was ist deepeval – KI-Tool für LLM Evaluation

Die Evaluation von Large Language Models stellt Unternehmen vor komplexe Herausforderungen. DeepEval bietet als innovatives Open-Source-Framework eine professionelle Lösung für diese Aufgabe.

Das von Confident AI entwickelte Tool unterstützt verschiedene KI-Modelle. Dazu gehören GPT, Gemini und Claude sowie Open-Source-Alternativen wie Llama oder Mistral.

DeepEval ermöglicht die systematische Bewertung von LLM-Ausgaben durch umfassende Metriken. Das Framework analysiert Accuracy, Faithfulness und Relevancy der generierten Inhalte.

Zusätzlich prüft das System auf Bias und Toxicity in den Modellantworten. Diese transparente Herangehensweise macht es zu einem wertvollen Werkzeug für technisch versierte Nutzer und Geschäftskunden.

Wichtige Erkenntnisse

- DeepEval ist ein kostenloses Open-Source-Framework für LLM-Evaluation

- Unterstützt sowohl kommerzielle als auch Open-Source-KI-Modelle

- Bietet umfassende Bewertungsmetriken für Genauigkeit und Relevanz

- Erkennt problematische Inhalte wie Bias und Toxicity automatisch

- Entwickelt von Confident AI für professionelle Anwendungen

- Ermöglicht objektive Qualitätsbewertung von KI-Ausgaben

Was ist deepeval – Definition und Grundlagen

Als spezialisiertes Python-Framework ermöglicht deepeval eine präzise und automatisierte Bewertung von LLM-Ausgaben. Das Framework wurde entwickelt, um die komplexen Herausforderungen bei der Evaluation von Large Language Models systematisch zu lösen. Es bietet Entwicklern und Unternehmen eine strukturierte Methode zur Qualitätssicherung ihrer KI-Anwendungen.

Einführung in das deepeval Framework

Das deepeval Framework basiert auf einem modularen Konzept von Test Cases. Jeder Test Case umfasst drei zentrale Komponenten: Input Prompt, Actual Output und Expected Output. Diese Struktur ermöglicht eine systematische Bewertung der Modellleistung.

Die Architektur des Frameworks zeichnet sich durch hohe Flexibilität aus. Es integriert nahtlos mit populären Machine-Learning-Bibliotheken wie PyTorch, TensorFlow und Hugging Face. Diese Kompatibilität erleichtert die Implementierung in bestehende Entwicklungsumgebungen erheblich.

Hauptzweck und Zielgruppe von deepeval

DeepEval richtet sich primär an Entwickler, Data Scientists und KI-Ingenieure, die professionelle LLM-Evaluation benötigen. Das Framework unterstützt sowohl Pass/Fail-Bewertungen als auch granulare 0-1-Scoring-Systeme. Diese Vielseitigkeit macht es für verschiedene Anwendungsszenarien geeignet.

Unternehmen nutzen deepeval zur Qualitätssicherung ihrer Conversational AI-Systeme. Forschungseinrichtungen schätzen die präzisen Bewertungsmetriken für wissenschaftliche Studien. Die deepeval erklärung zeigt, dass das Tool sowohl für Prototyping als auch für Produktionsumgebungen konzipiert wurde.

Abgrenzung zu herkömmlichen Testing-Methoden

Traditionelle Software-Tests fokussieren auf deterministische Ausgaben und binäre Erfolgs-/Fehlschlag-Bewertungen. DeepEval hingegen berücksichtigt die probabilistische Natur von Sprachmodellen. Es bewertet Nuancen wie Relevanz, Kohärenz und kontextuelle Angemessenheit.

| Aspekt | Herkömmliche Tests | DeepEval |

|---|---|---|

| Bewertungslogik | Binär (Pass/Fail) | Graduell (0-1 Score) |

| Ausgabentyp | Deterministisch | Probabilistisch |

| Evaluationskriterien | Exakte Übereinstimmung | Semantische Ähnlichkeit |

| Komplexität | Einfache Vergleiche | Mehrdimensionale Metriken |

Diese deepeval Erklärung verdeutlicht die Notwendigkeit spezialisierter Evaluation-Tools für moderne KI-Systeme. Das Framework schließt die Lücke zwischen traditioneller Softwarequalitätssicherung und den Anforderungen der KI-Entwicklung.

Die Bedeutung von LLM-Evaluation in der modernen KI-Entwicklung

Die Evaluation von Large Language Models stellt Entwickler vor völlig neue technische Herausforderungen. Traditionelle Software-Testing-Verfahren erweisen sich als unzureichend für die Bewertung probabilistischer Systeme. Die moderne KI-Entwicklung erfordert daher spezialisierte Ansätze und Werkzeuge wie deepeval.

Herausforderungen bei der Bewertung von Large Language Models

Large Language Models erzeugen bei identischen Eingaben unterschiedliche Ausgaben. Diese probabilistische Natur macht herkömmliche Testing-Methoden obsolet. Entwickler können nicht mehr auf deterministische Ergebnisse setzen.

Die Quantifizierung von Halluzinationen stellt eine weitere zentrale Herausforderung dar. LLM Testing erfordert neue Metriken zur Bewertung faktischer Konsistenz. Deepeval adressiert diese Problematik durch automatisierte Evaluationsprozesse.

Qualitätssicherung und Risikominimierung

Unzureichende Evaluation kann zu schwerwiegenden Produktionsfehlern führen. Falsche oder irreführende Ausgaben gefährden die Nutzervertrauen und Geschäftsergebnisse. Systematische LLM Testing-Verfahren minimieren diese Risiken erheblich.

Die folgende Tabelle zeigt kritische Evaluationsbereiche:

| Evaluationsbereich | Risikofaktor | Deepeval-Lösung |

|---|---|---|

| Faktische Genauigkeit | Hoch | Automatisierte Fact-Checking |

| Konsistenz | Mittel | Kohärenz-Metriken |

| Bias-Erkennung | Hoch | Fairness-Algorithmen |

| Toxizität | Sehr hoch | Content-Filter |

Compliance und ethische Aspekte

Regulatorische Anforderungen verschärfen sich kontinuierlich. Unternehmen müssen nachweisbare Evaluationsprozesse implementieren. LLM Testing wird zur Compliance-Notwendigkeit in regulierten Branchen.

Ethische KI-Entwicklung erfordert transparente Bewertungsverfahren. Deepeval ermöglicht die Dokumentation und Nachverfolgung von Evaluationsergebnissen. Dies schafft Vertrauen bei Stakeholdern und Regulierungsbehörden.

Kernfunktionen und technische Features von deepeval

Mit über 14 forschungsbasierten Metriken stellt deepeval ein robustes Werkzeug für die KI-Qualitätsbewertung bereit. Das Framework kombiniert bewährte Evaluationsmethoden mit innovativen Ansätzen zur systematischen Bewertung von Large Language Models. Die technische Architektur ermöglicht sowohl standardisierte als auch benutzerdefinierte Bewertungsverfahren.

Automatisierte Testverfahren und Evaluationsmetriken

Deepeval implementiert umfassende automatisierte Testverfahren, die eine kontinuierliche KI-Qualitätsbewertung ohne manuelle Eingriffe ermöglichen. Das System führt Tests parallel aus und generiert detaillierte Berichte über die Modellleistung. Die Automatisierung reduziert den Zeitaufwand für Evaluationen erheblich.

Das Framework unterstützt label-less Standard-Metriken, die ohne vorherige Datenaufbereitung funktionieren. Zusätzlich können Custom Metrics für spezifische Geschäftsanforderungen entwickelt werden. Diese Flexibilität macht deepeval für verschiedene Anwendungsbereiche geeignet.

Accuracy und Relevanz-Bewertung

Die Answer Relevancy-Metrik bewertet, wie präzise ein Sprachmodell auf gestellte Fragen antwortet. Faithfulness-Tests prüfen die Faktentreue der generierten Inhalte. Contextual Precision misst die Genauigkeit kontextbezogener Antworten.

G-Eval ermöglicht eine granulare Bewertung verschiedener Qualitätsaspekte. Diese Metriken arbeiten zusammen, um ein vollständiges Bild der Modellleistung zu erstellen. Die Ergebnisse werden in verständlichen Scores präsentiert.

Bias-Erkennung und Fairness-Tests

Integrierte Bias-Detection-Algorithmen identifizieren potenzielle Voreingenommenheiten in Sprachmodellen. Toxicity-Tests erkennen schädliche oder unangemessene Inhalte automatisch. Diese Funktionen sind essentiell für die KI-Qualitätsbewertung in produktiven Umgebungen.

Fairness-Tests bewerten, ob Modelle verschiedene Bevölkerungsgruppen gleichmäßig behandeln. Die Ergebnisse helfen Entwicklern, ethische Standards einzuhalten. Regelmäßige Bias-Checks gewährleisten kontinuierliche Compliance.

Integration in bestehende Entwicklungsumgebungen

Deepeval integriert sich nahtlos in gängige Entwicklungsworkflows und CI/CD-Pipelines. Das Framework unterstützt populäre Python-Bibliotheken und Testing-Frameworks. API-Schnittstellen ermöglichen die Anbindung an externe Systeme.

Die Integration erfolgt über einfache Import-Statements und Konfigurationsdateien. Entwickler können bestehende Testsuites erweitern, ohne grundlegende Änderungen vorzunehmen. Diese Kompatibilität beschleunigt die Implementierung erheblich.

Skalierbarkeit und Performance-Optimierung

Das Framework skaliert automatisch basierend auf der Testlast und verfügbaren Ressourcen. Parallele Verarbeitung optimiert die Ausführungszeit bei großen Evaluationsmengen. Memory-Management-Funktionen verhindern Ressourcenengpässe.

Performance-Monitoring liefert Einblicke in Systemauslastung und Bottlenecks. Caching-Mechanismen reduzieren redundante Berechnungen bei wiederholten Tests. Diese Optimierungen machen deepeval für Enterprise-Anwendungen geeignet.

deepeval Python Framework – Installation und Setup

Mit dem deepeval Python Framework erhalten Entwickler ein leistungsstarkes Werkzeug für die systematische Bewertung von Sprachmodellen. Die technische Implementierung erfordert eine strukturierte Herangehensweise. Das Framework unterstützt verschiedene LLM-Anbieter und bietet flexible Konfigurationsmöglichkeiten.

Die Installation erfolgt über den Python Package Manager. Entwickler können das Framework nahtlos in bestehende Entwicklungsumgebungen integrieren. Die Kompatibilität mit modernen Python-Versionen gewährleistet eine reibungslose Implementierung.

Systemanforderungen und Abhängigkeiten

Das deepeval python Framework benötigt Python 3.8 oder höher für den optimalen Betrieb. Die Systemarchitektur unterstützt sowohl Windows– als auch Unix-basierte Betriebssysteme. Zusätzliche Abhängigkeiten werden automatisch während der Installation verwaltet.

Erforderliche Komponenten umfassen numpy, pandas und requests-Bibliotheken. Die Speicheranforderungen variieren je nach verwendetem Sprachmodell. Eine stabile Internetverbindung ist für API-Aufrufe erforderlich.

Schritt-für-Schritt Installation

Die Installation beginnt mit dem Befehl pip install deepeval in der Kommandozeile. Der Package Manager lädt automatisch alle erforderlichen Abhängigkeiten herunter. Die Installationszeit beträgt typischerweise wenige Minuten.

„Die Installation von deepeval ist bewusst einfach gehalten, um Entwicklern einen schnellen Einstieg zu ermöglichen.“

Nach der erfolgreichen Installation können Nutzer die Funktionalität mit deepeval –version überprüfen. Das System bestätigt die korrekte Installation durch Ausgabe der Versionsnummer.

Erste Konfiguration und Grundeinstellungen

Die Grundkonfiguration erfordert die Einrichtung von API-Schlüsseln für die gewählten Sprachmodelle. OpenAI-Nutzer konfigurieren ihre Zugangsdaten über Umgebungsvariablen. Das Framework unterstützt standardmäßig gpt-4o anstelle des veralteten gpt-3.5-Modells.

Entwickler können verschiedene Modelle gleichzeitig konfigurieren. Die Konfigurationsdatei speichert Einstellungen persistent zwischen Sitzungen. Sicherheitsrichtlinien empfehlen die Verwendung von Umgebungsvariablen für sensible Daten.

Die initiale Testausführung validiert die korrekte Konfiguration aller Komponenten. Das deepeval python Framework bietet detaillierte Fehlermeldungen bei Konfigurationsproblemen.

Praktische Implementierung und Anwendung

Die Umsetzung von deepeval in realen Projekten beginnt mit der gezielten Vorbereitung von Testdaten und der Definition präziser Evaluationskriterien. Das Framework ermöglicht es Entwicklern, systematische Testverfahren zu etablieren, die eine zuverlässige Bewertung von Large Language Models gewährleisten.

Jeder deepeval Test Case besteht aus drei wesentlichen Komponenten: dem Input Prompt, dem tatsächlichen Output und dem erwarteten Output. Diese Struktur bildet das Fundament für alle Evaluationsprozesse.

Erstellung von Testszenarien

Die Entwicklung effektiver Testszenarien erfordert eine durchdachte Planung und Berücksichtigung verschiedener Anwendungsfälle. Deepeval unterstützt die Erstellung von Szenarien für Chatbots, Content-Generatoren und Multi-Agent-Systeme.

Dataset-Vorbereitung

Die Qualität der Testdaten bestimmt maßgeblich die Aussagekraft der Evaluation. Entwickler müssen repräsentative Datensätze zusammenstellen, die reale Nutzungsszenarien widerspiegeln.

Für medizinische Chatbots beispielsweise umfassen Testdatensätze typische Patientenanfragen und entsprechende Antwortmuster. Die Daten sollten verschiedene Komplexitätsgrade und Fachbereiche abdecken, um sprachmodelle bewerten zu können.

Präzise Testfall-Definitionen legen fest, welche Kriterien ein Sprachmodell erfüllen muss. Diese umfassen Genauigkeit, Relevanz und Konsistenz der generierten Antworten.

Jeder Testfall spezifiziert erwartete Outputs und definiert Toleranzbereiche für Abweichungen. Dies ermöglicht eine objektive Bewertung der Modellleistung.

Ausführung von Evaluationen

Die praktische Durchführung von Evaluationen erfolgt automatisiert über das deepeval Framework. Entwickler können Testläufe planen und verschiedene Modellversionen systematisch vergleichen.

„Automatisierte Evaluationen reduzieren den manuellen Aufwand erheblich und ermöglichen konsistente Qualitätsbewertungen.“

Das Framework generiert detaillierte Berichte, die Entwicklern helfen, sprachmodelle bewerten und Optimierungspotentiale zu identifizieren.

Monitoring und kontinuierliche Überwachung

Kontinuierliches Monitoring gewährleistet die langfristige Qualität von Sprachmodellen in Produktionsumgebungen. Deepeval bietet Funktionen zur Echtzeitüberwachung und Anomalieerkennung.

Entwickler können Schwellenwerte definieren und automatische Benachrichtigungen einrichten. Dies ermöglicht eine proaktive Qualitätssicherung und schnelle Reaktion auf Leistungsabweichungen.

Die Integration in bestehende CI/CD-Pipelines macht es möglich, sprachmodelle bewerten und kontinuierlich zu optimieren, ohne den Entwicklungsworkflow zu unterbrechen.

Bewertungsmetriken und KI-Qualitätsbewertung

Moderne KI-Qualitätsbewertung basiert auf etablierten Metriken und innovativen Evaluationsansätzen. Deepeval integriert bewährte Bewertungsverfahren mit spezialisierten Methoden zur umfassenden Leistungsanalyse. Das Framework ermöglicht objektive Qualitätsmessungen durch systematische Evaluationsprozesse.

Die Plattform unterstützt sowohl traditionelle Metriken als auch moderne Ansätze zur Halluzination-Erkennung. Entwickler erhalten präzise Werkzeuge für die ki qualitätsbewertung ihrer Sprachmodelle. Diese Kombination gewährleistet zuverlässige Ergebnisse in verschiedenen Anwendungsszenarien.

Standardmetriken für Sprachmodelle bewerten

Deepeval implementiert etablierte Bewertungsstandards für die systematische Qualitätsanalyse. Die Integration erfolgt nahtlos in bestehende Entwicklungsworkflows. Standardisierte Metriken ermöglichen vergleichbare Ergebnisse zwischen verschiedenen Modellen.

BLEU, ROUGE und semantische Ähnlichkeit

BLEU-Scores messen die Übereinstimmung zwischen generierten und Referenztexten durch N-Gramm-Vergleiche. ROUGE-Metriken bewerten die Qualität von Zusammenfassungen und Textgenerierung. Semantische Ähnlichkeitsmetriken analysieren die inhaltliche Übereinstimmung auf Bedeutungsebene.

Diese Metriken bilden das Fundament für objektive KI Qualitätsbewertung in der Textverarbeitung. Die Kombination verschiedener Ansätze liefert umfassende Bewertungsergebnisse. Entwickler können spezifische Metriken je nach Anwendungsfall auswählen.

Spezialisierte Algorithmen identifizieren faktische Ungenauigkeiten in generierten Inhalten. Das System vergleicht Ausgaben mit verifizierten Referenzdaten zur Wahrheitsprüfung. Moderne KI-Systeme lernen kontinuierlich aus diesen Bewertungsprozessen.

Faithfulness-Metriken bewerten die Treue zu Quelldokumenten und Eingabedaten. Answer Relevancy prüft die thematische Übereinstimmung zwischen Fragen und Antworten. Diese Verfahren minimieren das Risiko irreführender oder falscher Informationen.

Benutzerdefinierte Bewertungskriterien

Das G-Eval Framework ermöglicht die Definition spezifischer Bewertungsparameter für individuelle Anforderungen. Unternehmen können branchenspezifische Qualitätskriterien implementieren. Die Flexibilität unterstützt diverse Anwendungsfälle und Bewertungsstandards.

LLM-as-a-judge Methoden nutzen Sprachmodelle zur automatisierten Bewertung komplexer Reasoning-Aufgaben. Diese Ansätze erweitern die ki qualitätsbewertung um kontextuelle Intelligenz. Benutzerdefinierte Metriken passen sich an spezifische Geschäftsanforderungen an.

Benchmarking und Leistungsvergleiche

Systematische Benchmarks ermöglichen objektive Leistungsvergleiche zwischen verschiedenen Modellversionen. Standardisierte Testsuites gewährleisten reproduzierbare Ergebnisse. Die Vergleichsanalyse unterstützt datenbasierte Entscheidungen bei der Modellauswahl.

| Metrik-Kategorie | Anwendungsbereich | Bewertungsfokus | Ausgabeformat |

|---|---|---|---|

| BLEU/ROUGE | Textgenerierung | Syntaktische Ähnlichkeit | Numerischer Score |

| Semantische Metriken | Inhaltsbewertung | Bedeutungsebene | Ähnlichkeitswert |

| Halluzination-Erkennung | Faktentreue | Wahrheitsgehalt | Binäre Klassifikation |

| Custom Metrics | Spezialanwendungen | Individuelle Kriterien | Konfigurierbar |

Performance-Tracking dokumentiert Verbesserungen und Verschlechterungen über Zeiträume hinweg. Kontinuierliches Monitoring identifiziert Trends in der Modellleistung. Diese Daten unterstützen proaktive Optimierungsmaßnahmen für nachhaltige ki qualitätsbewertung.

deepeval Dokumentation und Community-Support

Eine strukturierte Dokumentation und lebendige Community unterstützen deepeval-Nutzer bei der praktischen Anwendung. Das Framework profitiert von umfassenden Ressourcen und kontinuierlicher Weiterentwicklung durch die Open-Source-Gemeinschaft. Diese Kombination macht deepeval zu einem zugänglichen Tool für Entwickler aller Erfahrungsstufen.

Offizielle Dokumentation und Ressourcen

Die deepeval Dokumentation bietet eine vollständige Referenz für alle Framework-Funktionen. Das GitHub Repository enthält detaillierte Installationsanleitungen, Code-Beispiele und API-Referenzen. Entwickler finden hier präzise Anweisungen für jeden Implementierungsschritt.

Zusätzliche Blog-Ressourcen erklären fortgeschrittene Anwendungsfälle und Best Practices. Die Dokumentation wird regelmäßig aktualisiert und spiegelt die neuesten Framework-Versionen wider.

Community-Beiträge und Open-Source-Entwicklung

Die aktive Open-Source-Community trägt kontinuierlich zur Weiterentwicklung bei. Entwickler teilen Erfahrungen, erstellen Tutorials und entwickeln Erweiterungen. Diese kollaborative Herangehensweise beschleunigt die Innovation und verbessert die Funktionalität.

Community-Beiträge umfassen Code-Verbesserungen, Fehlerbehebungen und neue Evaluationsmetriken. Die transparente Entwicklung ermöglicht es Nutzern, direkt am Fortschritt teilzuhaben.

Support-Kanäle und Hilfestellungen

Mehrere Support-Kanäle stehen für technische Fragen zur Verfügung. GitHub Issues bieten direkten Kontakt zu den Entwicklern. Community-Foren ermöglichen den Austausch zwischen Nutzern.

Zusätzlich bieten Video-Tutorials und Webinare praktische Einführungen. Diese vielfältigen Hilfestellungen gewährleisten eine effektive Problemlösung und beschleunigen den Lernprozess für neue Anwender.

Anwendungsfälle und Branchen-spezifische Einsatzgebiete

Von Großunternehmen bis zu Forschungseinrichtungen nutzen verschiedene Organisationen deepeval für ihre spezifischen Anforderungen. Das Framework bietet flexible Lösungen für unterschiedliche Branchen und Projektanforderungen. Die Vielseitigkeit zeigt sich in der breiten Palette von Einsatzszenarien.

Enterprise-Lösungen und Unternehmensanwendungen

Große Unternehmen setzen deepeval für llm testing in kritischen Geschäftsprozessen ein. Die Qualitätssicherung von KI-Systemen steht dabei im Mittelpunkt. Finanzdienstleister nutzen das Framework zur Bewertung von Chatbots im Kundenservice.

Technologieunternehmen implementieren deepeval für die Validierung ihrer Sprachmodelle. Die automatisierten Testverfahren reduzieren manuelle Aufwände erheblich. Compliance-Anforderungen werden durch systematische Evaluationen erfüllt.

Forschungseinrichtungen und akademische Projekte

Universitäten und Forschungsinstitute verwenden deepeval für wissenschaftliche Studien. Die Bewertung experimenteller Sprachmodelle erfolgt standardisiert und reproduzierbar. Akademische Teams profitieren von der Open-Source-Natur des Frameworks.

Forschungsprojekte im Bereich maschinelles Lernen nutzen deepeval für Benchmarking-Studien. Die detaillierten Metriken ermöglichen präzise Leistungsvergleiche zwischen verschiedenen Modellarchitekturen.

Produktionsumgebungen und MLOps-Integration

DevOps-Teams integrieren deepeval in ihre kontinuierlichen Deployment-Pipelines. Die nahtlose Einbindung in bestehende MLOps-Workflows optimiert Entwicklungsprozesse. Automatisierte llm testing Routinen gewährleisten konstante Modellqualität.

Cloud-Plattformen nutzen das Framework für Monitoring-Zwecke. Die Skalierbarkeit unterstützt auch große Produktionsumgebungen zuverlässig.

Chatbot und Conversational AI Testing

Conversational AI-Entwickler verwenden deepeval für umfassende Chatbot-Evaluationen. Die spezialisierten Metriken bewerten Dialogqualität und Kontextverständnis präzise. LLM testing für Gesprächsverläufe wird systematisch durchgeführt.

| Anwendungsbereich | Hauptnutzen | Typische Metriken | Zielgruppe |

|---|---|---|---|

| Enterprise-Lösungen | Qualitätssicherung | Accuracy, Compliance | Großunternehmen |

| Forschungsprojekte | Wissenschaftliche Bewertung | BLEU, ROUGE, Perplexity | Universitäten |

| MLOps-Integration | Automatisierung | Performance, Latenz | DevOps-Teams |

| Chatbot-Testing | Dialogbewertung | Contextual Relevance | AI-Entwickler |

Vorteile und Limitationen von deepeval

Eine objektive Analyse des deepeval frameworks zeigt sowohl bemerkenswerte Vorteile als auch spezifische Einschränkungen auf. Die systematische Bewertung ermöglicht eine fundierte Einschätzung der Framework-Eignung für verschiedene Projektanforderungen. Diese transparente Betrachtung unterstützt Entwickler bei der strategischen Technologieauswahl.

Einzigartige Stärken des Frameworks

Das deepeval framework zeichnet sich durch label-less Metriken aus, die eine Evaluation ohne vordefinierte Referenzdaten ermöglichen. Diese innovative Herangehensweise reduziert den Aufwand für die Testdatenerstellung erheblich. Die umfassenden Evaluationsmöglichkeiten decken verschiedene Aspekte der LLM-Performance ab.

Die entwicklerfreundliche Benutzerführung erleichtert die Integration in bestehende Workflows. Automatisierte Testverfahren minimieren den manuellen Aufwand bei der Qualitätssicherung. Die flexible Konfiguration passt sich an unterschiedliche Projektanforderungen an.

Vergleich mit alternativen LLM Testing Tools

Im direkten Vergleich mit RAGAS bietet deepeval eine breitere Palette an Evaluationsmetriken. Die Benutzerfreundlichkeit übertrifft viele alternative Lösungen durch intuitive APIs und klare Dokumentation. Andere Tools fokussieren oft auf spezifische Anwendungsbereiche, während deepeval universelle Einsatzmöglichkeiten bietet.

Die Performance-Optimierung zeigt Vorteile bei großen Datenmengen. Alternative Frameworks erfordern häufig komplexere Konfigurationen für vergleichbare Ergebnisse.

Bekannte Einschränkungen und Workarounds

Die Abhängigkeit von externen APIs kann zu Latenzproblemen führen. Workarounds umfassen lokale Caching-Strategien und Batch-Verarbeitung für bessere Performance. Die Dokumentation weist vereinzelt Lücken bei fortgeschrittenen Anwendungsfällen auf.

Ressourcenintensive Evaluationen erfordern entsprechende Hardware-Ausstattung. Die Community bietet praktische Lösungsansätze für diese technischen Herausforderungen. Regelmäßige Updates adressieren bekannte Limitationen kontinuierlich.

Fazit

DeepEval positioniert sich als wegweisendes Framework für die systematische Bewertung von Large Language Models in der modernen KI-Landschaft. Die Frage „Was ist deepeval?“ lässt sich präzise beantworten: Es handelt sich um eine umfassende Open-Source-Lösung, die standardisierte Metriken und anpassbare Protokolle für faire Vergleiche verschiedener Sprachmodelle bereitstellt.

Die modulare Architektur des Frameworks ermöglicht nahtlose Integration in bestehende Entwicklungsumgebungen wie TensorFlow, PyTorch und Hugging Face Transformers. Besonders hervorzuheben sind die automatisierten Bewertungsverfahren, die Batch-Evaluationen und skriptfähige Workflows unterstützen.

DeepEval adressiert kritische Herausforderungen der LLM-Entwicklung durch die Erkennung von Verzerrungen und Inkonsistenzen in Modellausgaben. Diese Funktionalität erweist sich als entscheidend für die Verbesserung von Fairness und Zuverlässigkeit across verschiedene demografische Gruppen.

Für Unternehmen und Forschungseinrichtungen bietet das Framework kontinuierliche Überwachungsmöglichkeiten, die langfristige Relevanz und Performance der implementierten Sprachmodelle sicherstellen. Die transparente Herangehensweise fördert ethische KI-Nutzung und unterstützt Compliance-Anforderungen in produktiven Umgebungen.

DeepEval etabliert sich als unverzichtbares Werkzeug für die professionelle LLM-Evaluation und trägt maßgeblich zur Entwicklung vertrauenswürdiger KI-Systeme bei.

FAQ

Was ist deepeval und wofür wird es verwendet?

Deepeval ist ein innovatives Open-Source-Framework zur Evaluation von Large Language Models (LLMs). Das Python-basierte Tool ermöglicht die systematische Bewertung der Qualität, Leistung und Zuverlässigkeit von Sprachmodellen durch automatisierte Testverfahren und umfassende Evaluationsmetriken. Es richtet sich primär an technisch versierte Entwickler, Datenanalysten und Unternehmen, die vertrauenswürdige KI-Systeme implementieren möchten.

Wie unterscheidet sich deepeval von herkömmlichen Testing-Methoden?

Im Gegensatz zu traditionellen Software-Tests, die deterministische Ergebnisse erwarten, ist deepeval speziell für die probabilistische Natur von LLMs konzipiert. Das Framework berücksichtigt die inhärente Variabilität von Sprachmodellen und bietet spezialisierte Metriken zur Bewertung von Aspekten wie Halluzination-Erkennung, semantischer Ähnlichkeit und Bias-Detection, die bei herkömmlichen Testing-Ansätzen nicht verfügbar sind.

Welche technischen Voraussetzungen sind für deepeval erforderlich?

Deepeval erfordert Python 3.7 oder höher sowie die Installation über pip. Die Systemanforderungen umfassen ausreichend RAM für die Modell-Evaluation und optional GPU-Unterstützung für bessere Performance. Zusätzlich werden API-Keys für die Integration externer Sprachmodelle wie OpenAI GPT oder Anthropic Claude benötigt, abhängig von den zu testenden Modellen.

Welche Bewertungsmetriken bietet deepeval für die LLM-Evaluation?

Das Framework unterstützt sowohl etablierte Metriken wie BLEU, ROUGE und METEOR als auch innovative Bewertungsverfahren für KI-Qualitätsbewertung. Dazu gehören Halluzination-Detection, Toxicity-Assessment, Bias-Evaluation und semantische Ähnlichkeitsmessungen. Zusätzlich ermöglicht deepeval die Definition benutzerdefinierter Bewertungskriterien für spezifische Anwendungsfälle und Qualitätsanforderungen.

Wie erfolgt die Installation des deepeval Python Frameworks?

Die Installation erfolgt über den Standard-Python-Paketmanager mit dem Befehl `pip install deepeval. Nach der Installation müssen die erforderlichen API-Keys konfiguriert und die Grundeinstellungen vorgenommen werden. Die deepeval Dokumentation bietet detaillierte Schritt-für-Schritt-Anleitungen für verschiedene Entwicklungsumgebungen und Konfigurationsoptionen.

Für welche Anwendungsbereiche eignet sich deepeval besonders?

Deepeval eignet sich hervorragend für Enterprise-Lösungen, akademische Forschungsprojekte und die Integration in MLOps-Pipelines. Besonders wertvoll ist das Framework für Chatbot-Testing, Conversational AI-Evaluation und die kontinuierliche Qualitätssicherung in Produktionsumgebungen. Unternehmen nutzen es zur Compliance-Überwachung und Risikominimierung bei KI-Anwendungen.

Welche Limitationen hat deepeval und gibt es Workarounds?

Die hauptsächlichen Einschränkungen umfassen die Abhängigkeit von externen API-Services, potenzielle Latenz bei großen Evaluationen und die Notwendigkeit technischer Expertise für erweiterte Konfigurationen. Workarounds beinhalten die Nutzung lokaler Modelle für sensible Daten, Batch-Processing für große Datensätze und die Implementierung von Caching-Strategien zur Performance-Optimierung.

Wo finde ich Unterstützung und Dokumentation für deepeval?

Die offizielle deepeval Dokumentation ist auf der GitHub-Seite verfügbar und bietet umfassende Anleitungen, API-Referenzen und Beispiele. Die aktive Open-Source-Community bietet Support über GitHub Issues, Diskussionsforen und Community-Beiträge. Zusätzlich stehen verschiedene Tutorials und Best-Practice-Guides für die praktische Implementierung zur Verfügung.

Wie integriert sich deepeval in bestehende Entwicklungsworkflows?

Das Framework bietet flexible Integrationsmöglichkeiten in CI/CD-Pipelines, MLOps-Workflows und bestehende Entwicklungsumgebungen. Durch die Python-basierte Architektur lässt sich deepeval nahtlos in Jupyter Notebooks, automatisierte Testing-Suites und Produktions-Monitoring-Systeme einbinden. Die modulare Struktur ermöglicht die schrittweise Implementierung ohne Disruption bestehender Prozesse.

Was macht deepeval zu einer professionellen Lösung für LLM-Testing?

Die professionellen Eigenschaften von deepeval umfassen die systematische Herangehensweise an LLM-Evaluation, die umfassenden Bewertungsmetriken und die Transparenz als Open-Source-Lösung. Das Framework bietet skalierbare Performance, kontinuierliche Weiterentwicklung durch die Community und die Flexibilität zur Anpassung an spezifische Unternehmensanforderungen, was es zu einer vertrauenswürdigen Lösung für Sprachmodelle bewerten macht.