Hosting Services

Als führendes IT-Systemhaus bieten wir Unternehmen und Firmen erstklassige Hosting- und Cloud-Angebote an. Dabei ist uns die regionale Nähe in Baden-Württemberg und Nordrhein-Westfalen besonders wichtig.

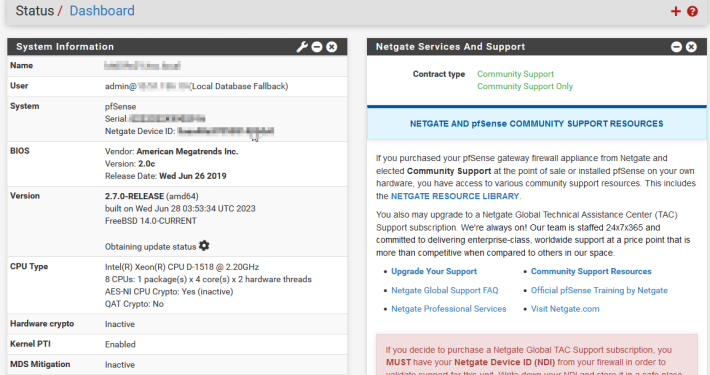

Wir betreiben in Baden-Württemberg und in Nordrhein-Westfalen mehrere Rechenzentren, die internationalen IT-Qualitäts-Standards genügen. Sicherheit, Redundanz (Ausfallsicherheit) und ein Höchstmaß an Verfügbarkeit werden dabei groß geschrieben.

Alle Rechenzentren sind mehrfach über unterschiedliche Leitungs-Anbieter (sog. Carrier) an den zentralen Carrier-Backbone des Internets in Deutschland angebunden. Das macht unsere Dienste und Cloud-Services besonders ausfallsicher. Selbstverständlich sind alle Systeme so ausgelegt, daß sie auch bei einem Stromausfall weiter arbeiten.

Die von uns betriebenen Systeme werden permanent überwacht und alarmieren im Notfall geschultes Personal zur Fehlerbehebung.

Die Cloud-Angebote des IT-Dienstleisters Biteno GmbH sind nach ISO 9001 sowie ISO 27001 qualitätsgesichert.

Cloud / Rechenzentrum-Services

Folgende Cloud-Angebote bietet die Biteno GmbH an:

- Domain-Registrierungen und Domain-Hosting (Webseiten)

- Email (Pop3, Imap)

- Hosted Exchange sowie gemanagte Exchange-Server

- Office 365

- Anbindung von Smartphones an Ihre Email-Infrastruktur

- Server Hosting (Linux und MS-Windows Server)

- Dedizierte Server als Windows Terminal Server, Citrix-Server, Exchange Server oder andere Anwendungen

- Software- und Serverdienste als SaaS (Software as a Service)

- Online Backup sowie Remote-Datensicherung (Datensicherung in ein entferntes Rechenzentrum)

- Cloud-Computing (Betrieb von SaaS Produkten)

- Server-Housing und Colocation von Hardware

Wir beraten Sie gerne ausführlich in einem persönlichen Gespräch. Nehmen Sie einfach Kontakt mit uns auf.